Comment la Shadow AI génère de la dette d'infrastructure

Les organisations répètent une erreur familière avec l’IA. Et cette fois, les conséquences arrivent plus vite et coûtent plus cher.

En avril 2023, Samsung Electronics a découvert que des ingénieurs avaient copier/coller du code propriétaire dans ChatGPT. En l’espace d’un mois, trois fuites de données distinctes ont exposé le code source d’équipements de semiconducteurs, des notes de réunions internes et des séquences d’optimisation de puces.

La perte était irréversible. Une fois que le code intègre les données d’entraînement de ChatGPT, il devient potentiellement accessible aux 100 millions d’utilisateurs mensuels du système. Samsung ne pouvait pas quantifier les dommages car ils ne pouvaient pas les mesurer. Comment évaluer des secrets commerciaux qui existent maintenant dans un système qu’on ne peut pas auditer ? Comment calculer l’avantage concurrentiel perdu lorsque vos approches d’optimisation de puces pourraient être reconstituées par des concurrents utilisant les mêmes outils d’IA ? L’industrie des semiconducteurs fonctionne avec des marges très serrées où même de petits avantages techniques se traduisent par des parts de marché valant des milliards.

Samsung a répondu par une interdiction générale des outils d’IA générative (GenAI), une décision qui les a immédiatement mis en position de faiblesse face à des rivaux qui intégraient l’IA plus prudemment. Des enquêtes ont montré plus tard que 65% des employés de Samsung comprenaient les risques de sécurité mais estimaient que les gains de productivité les justifiaient.

Cet incident, largement rapporté dans les médias technologiques à l’époque, illustre un schéma que l’on retrouve maintenant dans tous les secteurs. Les outils d’IA sont bon marché et contagieux.

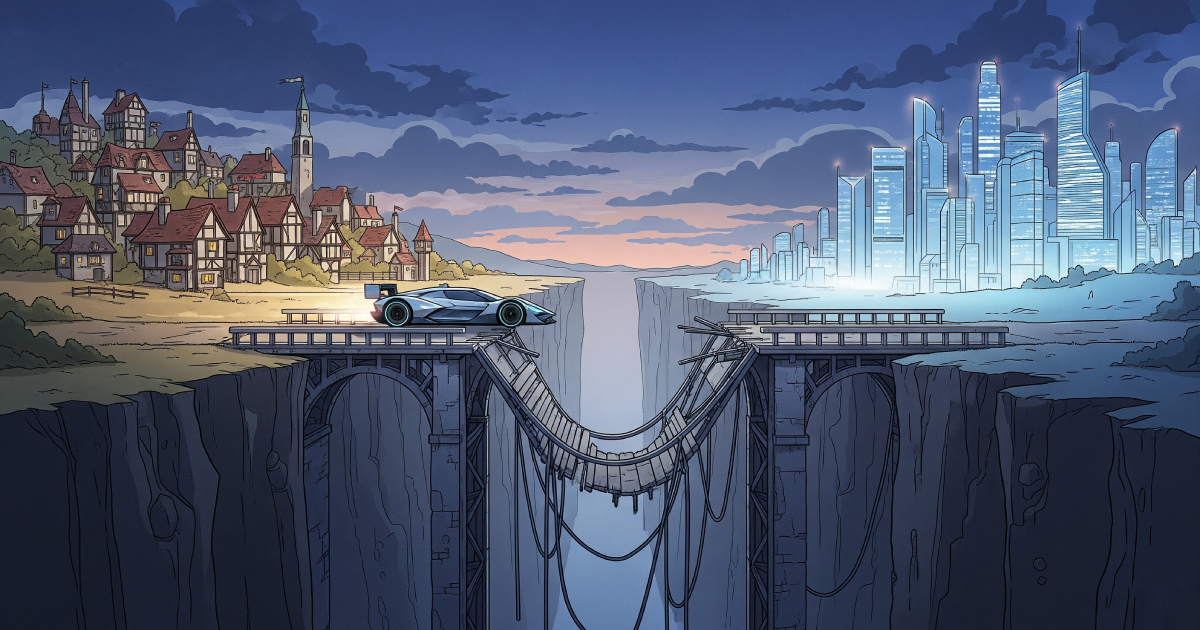

C’est un schéma visible depuis des décennies, que les dirigeants qui ont vécu les vagues technologiques précédentes devraient reconnaître. Les outils et technologies sont adoptés plus rapidement que les infrastructure organisationelles pour les déployer, optimiser et gouverner. Il en résulte une dette d’infrastructure qui s’additionne rapidement, coûteuse et souvent irréversible.

Avec le cloud computing, les entreprises qui ont simplement déplacé l’infrastructure sans repenser l’architecture ont vu des retours limités. Avec l’Agile, les organisations qui ont adopté les stand-ups et les sprints sans changer les rôles et les structures de prise de décision n’ont pas capturé la vélocité promise. Le même schéma s’applique avec l’IA. Mais cette fois, les conséquences arrivent plus vite et coûtent plus cher.

La dette d’infrastructure est prévisible

L’industrie technologique a la mémoire courte. Les changements majeurs de plateforme suivent généralement une trajectoire similaire : enthousiasme initial et adoption rapide d’outils, suivi d’un désordre croissant lorsque l’organisation découvre qu’elle manque d’infrastructure pour gérer ce qu’elle a déployé, puis une période douloureuse de remédiation réactive, et finalement, pour les survivants, une capture de valeur tardive une fois l’infrastructure appropriée en place.

W. Edwards Deming a observé avec justesse qu’“un mauvais système battra toujours une bonne personne”. Le travail de Deming sur la qualité et la pensée systémique, qui a transformé la fabrication dans les années 1950 et a ensuite influencé le développement logiciel, explique pourquoi l’adoption technologique sans transformation systémique échoue constamment : aucune compétence individuelle ne peut surmonter les contraintes structurelles.

Considérez la vague de migration vers le cloud des années 2010. Les organisations ont vu Amazon et Netflix récolter d’énormes bénéfices de leur infrastructure cloud et se sont précipitées pour les imiter. De nombreux dirigeants ont traité le cloud comme une simple opportunité de “lift and shift”. Elle ont simplement déplacé les applications existantes vers AWS ou Azure. La technologie fonctionnait mais sans intentionalité, cette nouvelle infrastructure ne répondait pas mieux aux business cases pour autant.

Certains sont tombé dans le même piège en suivant les mouvements Agile et DevOps. Les organisations qui ont adopté les cérémonies (stand-ups quotidiens, sprints de deux semaines, rétrospectives) sans changer les structures de prise de décision, les boucles de rétroaction et les interfaces entre les équipes ont constaté que l’Agile ne pouvait pas surmonter les contraintes organisationnelles. Les réunions de planification se déroulaient comme prévu, mais les décisions nécessitaient toujours six niveaux d’approbation. Les sprints étaient réglés comme une horloge, mais le déploiement prenait toujours trois mois car le processus de release n’avait pas changé.

Il n’y a pas de mystère. Comme l’enseigne la Théorie des Contraintes, chaque système a un facteur limitant qui régit la valeur qu’il peut délivrer. Accélérer une partie du système n’améliore pas la performance globale si la contrainte se trouve ailleurs. Lorsque les développeurs écrivent du code plus rapidement en utilisant l’IA, mais que ce code attend toujours des jours pour la revue, l’approbation et le déploiement, le système ne s’est pas accéléré. Le goulot d’étranglement s’est simplement déplacé. Certaines organisations ont réussi à traiter ces contraintes en aval et à capturer de réels gains de productivité, mais celles-ci représentent des exceptions plutôt que la norme.

La dynamique est prévisible, pourtant, nous en sommes à nouveau là avec l’IA. La différence cette fois est la vélocité : l’adoption de l’IA se produit si rapidement que le fossé entre l’adotion et la mise en place de nouvelles capacités d’infrastructure crée des problèmes à une vitesse et une échelle sans précédent.

Pourquoi l’IA rend le fossé catastrophique

L’adoption de l’IA diffère des vagues technologiques précédentes de trois manières critiques qui rendent la dette d’infrastructure beaucoup plus dangereuse : la vitesse d’adoption ne laisse aucun temps pour une préparation systèmique, l’accessibilité des outils permet un déploiement non contrôlé universel, et les enjeux impliquent la propriété intellectuelle et la conformité réglementaire, ce qui n’était pas le cas des outils précédents.

La vélocité de l’adoption est sans précédent. Dans les 18 mois suivant la sortie publique de ChatGPT, l’utilisation de l’IA dans le développement logiciel a atteint 78%, les dépenses passant de 2,3 milliards à 13,8 milliards de dollars. Une multiplication par six (Stanford HAI AI Index, 2025). A titre de comparaison, l’adoption du cloud a pris près d’une décennie pour atteindre une pénétration similaire. Cette vitesse signifie que le fossé d’infrastructure se creuse non pas sur des années mais en quelques semaines.

Plus préoccupantr est la dynamique d’accessibilité. Les technologies précédentes (infrastructure cloud, systèmes d’intégration continue, orchestration de conteneurs, etc.) nécessitaient des connaissances spécialisées et un provisionnement explicite. Un développeur individuel ne pouvait pas simplement créer un cluster Kubernetes pour la production sur sa carte de crédit personnelle. Les outils d’IA n’ont pas de telles barrières. Un abonnement mensuel de 20 $ à Claude ou ChatGPT donne à n’importe quel développeur des capacités puissantes sans avoir à consulter l’IT. Cette faible barrière à l’entrée est une épée à double tranchant. Elle permet d’innover rapidement mais crée une tâche aveugle dans la gouvernance qui persiste jusqu’au premier incident majeur.

Et lorsqu’un employé quitte l’entreprise, il emporte avec lui son abonnement personnel à un outil d’IA et ses workflows. Ce qui devrait être une capacité institutionelle devient un savoir tribal qui peut disparaitre : Des prompts non documentés, des intégrations personnalisées, des gains de producticité et des racourcis dont l’organisation n’a même pas conscience de bénéficier jusqu’à ce que l’absence d’une seule personne ne les mettent en lumière. L’IA transforme la friction des départs en un risque de continuité pour l’activité.

Cela crée ce que nous appelons l’économie de la Shadow AI, et son ampleur est considérable. Alors que seulement 40% des entreprises déclarent avoir acheté des abonnements officiels d’IA, plus de 90% des employés disent utiliser régulièrement ces outils dans le cadre de leur travail (State of AI in Business Report, 2025). Ce n’est pas qu’une utilisation passive. Les développeurs intègrent ces outils dans leurs flux de travail quotidiens, souvent plusieurs fois par jour, traitant le code et les données de l’entreprise à travers des systèmes sur lesquels l’organisation n’a aucune visibilité, aucune gouvernance et aucun contrôle.

Les conséquences de ce fossé de visibilité s’étendent bien au-delà du cas de Samsung. Dans les institutions financières, les CTO signalent des incidents de production hebdomadaires dus à du code généré par l’IA et intégré sans une révision insuffisante. Le PDG de la société de qualité de code Sonar a relayé qu’une grande banque connaissait “une panne par semaine” parce que les développeurs examinaient le code généré par l’IA moins attentivement que leur propre travail, avec la mentalité “ce n’est pas mon code”. Chaque incident coûtait des centaines de milliers de dollars en remédiation et écornait de plus en plus la confiance des clients.

Le rapport 2024 d’IBM sur le coût des violations de données quantifie le surcout du Shadow AI : les organisations connaissent des coûts de violation moyens supérieurs de 670 000 $ lorsque la Shadow AI est impliquée, avec des augmentations substantielles du temps de détection et de la complexité de remédiation.

Même dans un cadre officiel, les entreprises se précipitant pour déployer la GenAI découvrent souvent que leurs données ne sont pas connectées, leurs systèmes ne peuvent pas évoluer, et qu’elles manquent de visibilité sur l’utilisation.

En Europe l’AI Act, mise en œuvre en 2024, fait passer ces lacunes du status de dette technique à celui de violations réglementaires. Les entreprises ont la responsabilité légale de démontrer leur bonne gouvernance de l’IA : documenter la traçabilité des données, les décisions des modèle et les modes d’utilisation.

Ce cadre réglementaire crée des dynamiques concurrentielles : les entreprises qui ont construit une infrastructure appropriée suffisement tôt peuvent facilement démontrer leur mise en conformité. Celles qui rattrapent leur retard font face à de la remédiation technique et s’exposent à des sanctions. L’AI Act a une approche basée sur les risques, ce qui signifie que les exigences sur l’infrastructure évoluent avec la criticité du cas d’usage. Dans le domaine de la santé, analyser les données des patients nécessitent une gouvernance plus rigoureuse que de générer des campagnes marketing. Cette approche par niveaux renforce l’idée que les exigences d’infrastructure doivent correspondre au contexte organisationnel, et non pas suivre des mandats universels.

Le fossé entre l’IA et l’infrastructure permettant d’en tirer le meilleur parti n’est pas seulement une question de coût, mais d’exposition à un risque potentiellement existentiel dont la plupart des dirigeants n’ont pas conscience.

L’Infrastructure crée la différence entre le chaos et la capacité

Le Platform Engineering a émergé comme réponse organisationnelle à la dette d’infrastructure, bien que le terme masque ce qui est réellement en jeu. Le Platform Engineering n’est pas une question de technologie. Il s’agit de construire une infrastructure organisationnelle qui permet aux développeurs d’avancer rapidement tout en prévenant l’adoption d’initiatives chaotiques et la dégradation de la qualité que la Shadow AI crée.

Le défi est que le Platform Engineering est légitimement difficile à mettre en œuvre avec succès. Les organisations qui y parviennent obtiennent des résultats transformateurs. Celles qui n’y parviennent pas empirent souvent les choses en ajoutant de la friction sans ajouter de valeur.

Le cas d’usage de Spotify illustre en quoi le Platform Engineering bien exécuté peut transformer une plateforme de contrainte à catalyseur.

En 2018, les efforts de machine learning de Spotify étaient fragmentés entre les équipes. Les data scientists passaient des semaines à configurer leur infrastructure avant de pouvoir entraîner un seul modèle. L’intégration de nouveaux ingénieurs ML prenait plus de 40 jours, principalement à attendre l’accès aux systèmes, à naviguer dans des processus non documentés et à reconstituer des connaissances tribales.

L’entreprise a alors mis en place ML Home, une plateforme centralisée qui concrétisait une décision stratégique : traiter les développeurs internes comme des clients, pas comme des risques de conformité. Cette nouvelle plateforme a permis aux équipes de réduir le temps passé à configurer leurs infrastructures, passant de plusieurs semaines à quelques heures. Les nouveaux ingénieurs atteigaient leur dixième pull request en moins de 20 jours. Une réduction de 55%.

Ces résultats illustrent ce qui arrive lorsque les équipes en charge de la plateforme se concentrent sur la livraison de valeur plutôt que sur l’application d’un mandat. ML Home a atteint 99% d’adoption volontaire parce qu’il facilitait le travail. Les utilisateurs actifs quotidiens ont augmenté de 200% la première année. La plateforme suit maintenant plus de 220 projets ML et permet une productivité équivalente à trois ingénieurs à temps plein supplémentaires par dix développeurs.

La transformation de Spotify nous apprends une leçon plus large. Les organisations qui construisent avec succès une infrastructure se concentrent sur la résolution des points de friction réels des développeurs, rendent les canaux officiels plus faciles à utiliser que leurs alternatives, et mesurent le succès par l’adoption et la satisfaction plutôt que par le nombre de fonctionnalités.

Avant d’examiner les causes d’échec du Platform Engineering, je dois reconnaître mon biais : je dirige moi même une telle équipe. Cela me donne à la fois une expertise approfondie de ce qui fonctionne et un aveuglement institutionnelle aux alternatives. Les preuves que je présente sont réelles, mais mon interprétation favorise forcément une solution spécifique. Jugez en conséquence.

Pourquoi le Platform Engineering échoue : Un problème de design organisationnel

La vérité qui dérange et dont la communauté discute rarement est que la plupart des implémentations échouent. Non pas en raison d’une inadéquation technique, mais en raison d’un décalage avec le design organisationnel qu’aucune solution technique ne peut surmonter.

Un thème récurent émerge de mes discussions avec des leaders en Platform Engineering : l’échec du “Si tu le construis, ils viendront”. Typiquement, une entreprise logiciels de 500 personnes investit 1 à 3 millions de dollars pour embaucher des ingénieurs expérimentés. Des anciens de sociétés comme Netflix ou Google, qui déployent Kubernetes et des outils d’observabilité modernes, et suivent les meilleures pratiques pour passer à l’échelle. Tout ça pour que dix-huit mois plus tard, l’adoption se situe entre 20 et 30%.

L’erreur fondamentale dans ces cas là est d’avoir traité le platform engineering comme un défi technique plutôt qu’un défi produit. Les équipes se concentrant entièrement sur les capacités de la platform sans valider qu’ellent résolvent les problèmes que les développeurs expérimentent réellement au quotidien. Lorsque les entreprises font le post-mortem des projets, elles découvrent systématiquement que les vrais problèmes de leurs développeurs (accès à la base de données, documentation du code legacy, coordination inter-équipes) ressemblent peu à ce que la plateforme fournit.

La seconde erreur commune est de tomber dans le piège du ticket-ops. Les équipes plateforme deviennent des distributeurs automatiques, répondant aux demandes qui s’empilent sans réussir à dégager une vision. Ensevelies dans des requêtes ponctuelles, ne construisant jamais de capacités en libre-service, les ingénieurs plateforme et les développeurs deviennent frustrés. Les premiers par un labeur sans fin, les derniers par des temps de réponse trop lents.

La recherche sur les échecs des pilotes d’IA révèle des schémas organisationnels similaires. L’étude du MIT sur les initiatives d’IA générative a montré que 95% échouent à atteindre la production. Les barrières sont organisationnelles : résistance à l’adoption de nouveaux outils, problème de qualité liées à une mauvaise intégration, manque de soutient exécutif et gestion du changement difficile.

Le paradoxe est instructif. Les mêmes travailleurs du savoir qui utilisent ChatGPT quotidiennement pour des tâches personnelles décrivent les outils d’IA d’entreprise comme peu fiables. Ils intègrent l’IA grand public dans leurs flux de travail de manière transparente mais résistent aux outils officiels. La technologie est identique, ce qui diffère est l’enveloppe organisationnelle. Les outils grand public apprennent au cours de l’utilisation et s’adaptent aux besoins. Les outils d’entreprise, contraints par des cadres de gouvernance qui priorisent le contrôle sur l’expérience, n’en sont souvent pas capables et deviennet ainsi rapidement obsolètes.

Approches alternatives : Quand le platform engineering n’est pas la réponse

Le platform engineering représente une réponse à la dette d’infrastructure, mais ce n’est pas la seule approche viable. Et pour de nombreuses organisations, ce n’est pas la bonne. Trois alternatives méritent considération :

- Accepter et Optimiser pour le Chaos. Certaines organisations, en particulier les petites entreprises ou celles dans des contextes évoluant rapidement, font un choix stratégique explicite : avancer rapidement, accepter la Shadow AI et gérer le risque par d’autres moyens. Elles investissent dans la réponse rapide aux incidents, une assurance cyber-risques complète et une responsabilité individuelle claire plutôt que dans une gouvernance centralisée. Cela fonctionne lorsque la vélocité l’emporte sur l’exposition au risque, lorsque l’organisation est assez petite pour que la coordination informelle suffise, ou lorsque le paysage concurrentiel exige une vélocité maximale. Le compromis est compris et intentionnel : risque d’incident plus élevé et exposition potentielle à des défauts de conformité en échange de l’absence friction de gouvernance.

- Acheter la gouvernance-as-a-service. Plutôt que de construire des capacités de plateforme internes, les organisations peuvent acheter des outils de gouvernance d’IA spécialisés auprès de fournisseurs comme WrangleAI, Harmonic Security, ou des fournisseurs intégrant la gouvernance d’IA dans les plateformes existantes. Cette approche a du sens pour les organisations de moins de 100 développeurs qui ne peuvent pas justifier un personnel dédié, pour les entreprises avec une sophistication technique limitée, ou pour celles qui ont besoin de gouvernance plus vite qu’elles ne peuvent la construire en interne. La limitation : ces outils fournissent visibilité et contrôle mais ne rendent pas les canaux officiels plus rapides que les alternatives de Shadow AI.

- Responsabilité Fédérée Sans Plateformes Centrales. Certaines organisations décentralisent radicalement l’adoption de l’IA, donnant la responsabilité de gouvernance aux équipes elles mêmes. Chaque équipe fait ses propres choix d’outils mais porte l’entière responsabilité de la sécurité, de la conformité et des coûts. Cela fonctionne dans les organisations avec une haute maturité d’ingénierie, un leadership fort au niveau de l’équipe et des mécanismes de responsabilité clairs. L’avantage : autonomie et flexibilité maximales. Le risque : incohérence, efforts dupliqués et lacunes de gouvernance entre les équipes.

Le Platform Engineering a du sens lorsque les organisations remplissent des conditions spécifiques : elles sont assez grandes pour financer des équipes dédiées (généralement 250+ développeurs), elles font face à des exigences réglementaires nécessitant une gouvernance centralisée, elles ont les moyens de négocier l’achat, et elles sont prêtes à investir 12-24 mois avant d’obtenir des retours. Pour les organisations ne remplissant pas ces critères, les approches alternatives peuvent être plus appropriées.

Maintenant, si l’on est honnête il faut reconnaitre que la plupart des organisations lisant ceci ont déjà une adoption significative du Shadow AI. Pratiquement aucune ne va constuire son infrastructure IA de zéro, il va surtout s’agit de remédier au chaos existant. Cela change significativement l’équation. La remédiation nécessite des tactiques différentes de la prévention : outils de découverte pour trouver ce qui existe, stratégies de migration pour déplacer les utilisateurs des outils fantômes vers les outils sanctionnés, et gestion du changement pour surmonter la résistance des personnes dépendantes des outils que vous remplacez.

La question d’échelle compte aussi plus que les défenseurs du platform engineering (moi y compris) l’admettent généralement. Une startup de cinq personnes et une entreprise de 5 000 personnes ont toutes deux besoin de gouvernance, mais les solutions appropriées diffèrent radicalement. La startup met en œuvre la gouvernance par des politiques claires et un ingénieur senior consacrant 20% du temps aux préoccupations liée à la plateforme. L’entreprise a besoin d’équipes dédiées. Les principes restent cohérents : visibilité, activation et gouvernance. Mais l’implémentation change radicalement.

La fenêtre se referme : Pourquoi le timing compte

Une question que les dirigeants devraient se poser : quand devrions-nous agir ?

Les faits indiquent qu’il existe une fenêtre étroite entre la reconnaissance du problème et le moment où il devient prohibitivement coûteux à corriger. Les organisations qui construisent leur infrastructure de manière proactive, avant le premier incident de sécurité majeur, avant que la Shadow AI ne devienne profondément enracinée, avant que la dette technique ne se compose, capturent de la valeur plus tôt et évitent les coûts de remédiation en mode crise.

Cette fenêtre se rétrécit plus rapidement avec l’IA qu’avec les vagues technologiques précédentes. L’adoption du cloud était assez lente pour que les organisations aient des années pour réagir. La transformation Agile pouvait être pilotée dans de petites équipes avant d’évoluer. L’adoption de l’IA se produit si rapidement que l’écart entre “nous devrions probablement faire quelque chose” et “nous sommes en crise” se mesure en mois, pas en années.

Les données suggèrent trois scénarios distincts basés sur le timing :

- Les organisations agissant maintenant (avant les incidents majeurs) peuvent construire l’infrastructure délibérément, expérimenter avec des modèles de gouvernance et établir des pratiques pendant que la Shadow AI est encore gérable. Elles capturent des gains de productivité tout en évitant les surcoûts de remédiation et les violations de conformité induits par un usage non-encadré. L’investissement est stratégique, non réactif.

- Les organisations attendant le premier incident font face à un calcul différent. Après une fuite de donnée comme celle ayant affecté Samsung ou un échec en production majeur, l’investissement dans l’infrastructure devient une réponse à une crise. La pression pour avancer rapidement crée des raccourcis. La gouvernance devient lourde plutôt qu’habilitante car l’accent est mit sur le contrôle des dégâts et non la création de valeur. Les développeurs qui sont devenus dépendants des leur abonnement personnel à des outils d’IA résistent à la centralisation. La dette technique s’est accumulée au point où les coûts de remédiation se multiplient.

- Les organisations qui attendent plusieurs années découvrent que l’IA fantôme est devenue si intégrée que la centralisation est pratiquement impossible. Des centaines d’outils sont utilisés. Les développeurs ont construit des flux de travail critiques autour de systèmes non approuvés. Tenter de centraliser déclenche une résistance massive car vous enlevez des outils dont les gens dépendent. Certaines organisations dans ce scénario acceptent simplement la fragmentation permanente et optimisent pour la gouvernance du chaos plutôt que la gouvernance de l’ordre.

Les implications financières diffèrent radicalement. Les organisations construisant leur infrastructure de manière proactive rapportent des périodes de retour sur investissement de 12-24 mois avec des économies de coûts documentées de 15-30%. Celles répondant aux incidents dépensent des montants comparables mais évitent principalement les pertes supplémentaires plutôt que de capturer des gains. Celles en mode crise permanente paient des coûts premium indéfiniment. La prime de violation de conformité de 670 000 $ devient un coût récurrent obligatoire pour continuer à fonctionner.

En faisant de l’investissement dans l’infrastructure le prérequis explicite pour l’adoption élargie de l’IA, vous pouvez espérer obtenir : la visibilité des coûts en temps réel déployée sous 60 jours, des quality gates automatisées pour le code généré par l’IA sous 90 jours, le provisionnement en libre-service pour les outils approuvés sous six mois.

L’observabilité des coûts est le type de problème que les équipes plateforme rencontrent fréquemment. Elles peuvent être due à des expériences non autorisées intensives en GPU ou du traitement de données sensibles par des instances non approuvées. En prévenant un seul incident, qui peut se transformer en violation de conformité, l’investissement d’infrastructure se rentabilise.

Plus important encore, la culture doit changer. Les développeurs devraient pouvoir demander des outils d’IA via l’équipe plateforme ou tout autre canal officiel en mesure de les provisionner en quelques heures avec une gouvernance intégrée. De cette façon, l’adoption des outils officiels augmente tandis que l’utilisation d’outils personnels diminue. La plateforme n’a pas besoin d’être parfaite mais de devenir le chemin de moindre résistance plutôt que l’obstacle à éviter.

Au-delà de l’IA

La leçon de l’adoption du cloud, de l’Agile et de l’IA est claire : l’infrastructure organisationnelle doit évoluer en parallèle avec l’adoption des outils, ou les outils favoriserons le chaos plutôt que l’émergence de nouvelles capacités. Ce n’est pas spécifique à l’IA. C’est un principe fondamental de transformation technologique que les dirigeants ont tendance à sous-estimer.

Cette leçon suggère une approche différente de l’adoption technologique. Au lieu de demander “Quels outils devrions-nous acheter ?” les dirigeants devraient se demander “De quelle infrastructure organisationnelle avons-nous besoin pour capturer la valeur de ces outils ?”. Il ne s’agit pas d’acheter ou non GitHub Copilot ou ChatGPT Enterprise, mais de construire ou non les capacités de plateforme qui rendent ces outils productifs plutôt que problématiques.

Ce recadrage a des implications significatives sur la façon dont les investissements technologiques sont évalués. Les calculs de ROI traditionnels se concentrent sur les coûts d’outils versus les gains de productivité : “Si les développeurs vont 30% plus vite, nous économisons X dollars de salaire.” Mais l’équation réelle inclut les coûts d’infrastructure, les frais généraux de gestion de la qualité, les systèmes de sécurité et de conformité, et le coût d’opportunité de l’adoption du Shadow AI. Le plus souvent, les outils sont le plus petit poste de dépense. En fait, l’augmentation de la vélocité des développeurs grâce à l’utilisation de l’IA s’accompagne souvent d’un taux de churn de code et d’instabilité plus élevé.

Ce n’est que lorsque ces capacités d’infrastructure existent que l’adoption d’outils a du sens stratégique. Cela inverse la séquence typique. Au lieu d’adopter des outils et de se démener pour construire l’infrastructure de manière réactive, les organisations construisent l’infrastructure d’abord et adoptent les outils délibérément.

Les études suggèrent que cette approche fonctionne. Les organisations avec des capacités de plateforme matures réalisent des gains de productivité de 15-55% grâce à l’adoption de l’IA et des économies de coûts de 30-83% grâce à la gestion consolidée.

Alors que les capacités des outils d’IA s’accélèrent et que de nouveaux émergent chaque mois, le fossé d’infrastructure s’élargira probablement pour les organisations qui n’investissent pas délibérément. La fenêtre pour construire une infrastructure propice avant la prochaine vague technologique se rétrécit. Les entreprises qui reconnaissent l’infrastructure comme un investissement stratégique plutôt que des frais opérationnels se mettent en position pour capturer un avantage disproportionné. Celles qui continuent de traiter l’infrastructure comme un moyens de remédier à des problèmes après-coup découvriront probablement, de manière répétée et douloureuse, que les outils bon marché créent un chaos coûteux.

La tendance est clair. La fenêtre se ferme.

References

- Google Cloud DORA (DevOps Research and Assessment). “Accelerate State of DevOps 2024.” Google Cloud, 2024.

- Google Cloud DORA. “2025 State of AI-Assisted Software Development.” Google Cloud, January 2025.

- IBM Security. “Cost of Data Breach Report 2024.” IBM Corporation, July 2024.

- Shrikanth, Nick and Omri Zur. “Coding on Copilot: 2023 Data Suggests Downward Pressure on Code Quality.” GitClear, January 2024.

- Stack Overflow. “2025 Developer Survey.” Stack Overflow, May 2025.

- Stanford Institute for Human-Centered Artificial Intelligence. “The 2025 AI Index Report.” Stanford HAI, March 2025.

- METR (Model Evaluation & Threat Research). “Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity.” METR, July 2025.

- The GenAI Divide STATE OF AI IN BUSINESS 2025. MIT Nanda.

- Cloud Native Computing Foundation. “Platform Engineering Maturity Model.” CNCF, 2024.

- Lopa, Maisha. “Product Lessons from ML Home: Spotify’s One-Stop Shop for Machine Learning.” Spotify Engineering Blog, January 19, 2022.

- Samsung Electronics data leak incidents, April 2023. Multiple news sources including Bloomberg Technology, Reuters Technology, and industry analysis reports.

Methodology and Sources

Cet article synthétise des données provenant de plusieurs études de recherche faisant autorité menées entre 2024-2025 :

Sources quantitatives principales :

- Google DORA (DevOps Research and Assessment), “Accelerate State of DevOps 2024” and “2025 State of AI-Assisted Software Development” (90,000+ respondents globally)

- IBM Security, “Cost of Data Breach Report 2024” (industry-wide breach cost analysis)

- GitClear, “Coding on Copilot: 2023 Data Suggests Downward Pressure on Code Quality” (analysis of 211 million changed lines of code, 2020-2024)

- Stack Overflow, “2025 Developer Survey” (65,000+ developers)

- Stanford HAI, “2025 AI Index Report” (global AI investment and adoption tracking)

- CNCF (Cloud Native Computing Foundation), Platform Engineering Maturity Model surveys

- MIT/METR (Model Evaluation & Threat Research), “Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity”

Études de cas :

- Spotify and Airbnb platform transformations: From published engineering blog posts and conference presentations

- Samsung Electronics incident (April 2023): Based on widely reported public incidents and subsequent analysis.

- Platform engineering success and failure cases: Direct interviews with CTOs and platform engineering leaders conducted between August 2024 - September 2025, with permission granted for anonymized use.